AV Comparatives: 21 Antivirenprodukte im Langzeittest

Wie man Antivirenlösungen korrekt testet, beschäftigt die IT-Security-Branche schon lange. Kritik an den Testmethoden kam indes – wenig überraschend – oft von denen, die in den Tests schlecht abgeschnitten hatten. Sie wurde daher in der breiten Öffentlichkeit auch nicht zu ernst genommen. Im Frühjahr kam es jedoch zwischen der Stiftung Warentest und den Security-Herstellern zu einem regelrechten Eklat.

Anlass war der damals aktuelle Test der Stiftung. Der prüfe im Wesentlichen die signaturbasierende Erkennung von inaktiver Schadsoftware, es sei eine zu geringe Zahl an Programmen geprüft worden und außerdem sei das Testszenario zu wenig transparent, so die Kritik der Hersteller. Die Angegriffenen dementierten alle diese Punkte vehement.

Nicht zuletzt, so die Hersteller weiter, sei die Tatsache, dass die Software – zumindest zeit- und teilweise – auf Rechnern ohne Internetzugang unter die Lupe genommen wurde, gelinde gesagt veraltet. Schließlich würden so Security-Suiten, die stark auf signaturbasierende Erkennung von Malware setzten unverhältnismäßig bevorzugt. Moderne Programme dagegen, die für die Erkennung auf cloud-basierende Elemente setzen, seien stark benachteiligt.

Damit erklärten zumindest McAfee, Symantec und auch Trend Micro ihr bescheidenes Abschneiden im Test der Stiftung Warentest. Andere, zum Beispiel Panda Software, hatten unter denselben Problemen zu leiden. Und Kaspersky, das in dem Test gut wegkam, schloss sich der Kritik der Testverlierer weitgehend an. Nahezu einhellig lobten die von Warentest abgewatschten Unternehmen das Magdeburger Labor AV-Test und die Prüfer von AV Comparatives in Innsbruck.

Letztere haben jetzt die Zusammenfassung ihrer mit Spannung erwarteten Ergebnisse der Tests für die Monate März bis Juni vorgelegt. Für die qualitative Beurteilung von Malwarescannern haben die Innsbrucker das von ihnen als “Whole Product Dynamic Real-World Protection Test” bezeichnete Szenario entwickelt. Es erhebt den Anspruch, “aktuelle Sicherheitsprodukte direkt mit den bekannten und unbekannten Gefahren des Internets, auf die ein normaler Anwender beim täglichen Surfen stoßen könnte” zu konfrontieren.

Im Test der Innsbrucker geht es erstens um das gesamte Produkt, in der Regel also die von den Herstellern als “Internet Security Suite” beworbenen Softwarepakete. Zweitens werden keine Einzelanalysen unter Laborbedingungen durchgeführt, etwa Scan-Tests, bei denen – vereinfacht gesagt – die Software auf eine Festplatte voller Viren losgelassen wird, oder Performance-Tests, die lediglich ermitteln, inwieweit die Software die Systemleistung des Rechner beeinträchtigt.

“Erst das Zusammenführen aller Testergebnisse, die ermittelt werden konnten, zeigt die wahre Leistungsfähigkeit einer Software. Die Beurteilung von Erkennungsrate, Performance, Rechnerbelastung und Fehlalarmen liefert unter Realbedingungen genaue Ergebnisse. Und sie erfasst Begleiterscheinungen, die möglicherweise in einem Laborcheck nicht zum Tragen kommen”, erklären die Österreicher in einer Presseaussendung zu ihren Tests.

Der “Real-World Protection Test”

Seit März 2012 erfolgt der “Real-World Protection Test” monatlich. AV Comparatives verkürzte das Testintervall von quartalsweise auf monatlich, damit Verbesserungen, die die Hersteller aufgrund der gewonnen Messdaten vornehmen, zeitnah berücksichtigt werden. Zweimal jährlich veröffentlicht AV Comparatives alle Ergebnisse in einem Bericht, der kostenlos auf der Webseite veröffentlicht wird.

Absichtlich publiziert AV Comparatives die monatlichen Ergebnisse allerdings nicht, sondern fasst die Ergebnisse mehrerer Monate zusammen. Damit will man vermeiden, dass Hersteller die Zahlen einzelner Monate zu Werbezwecken aufbauschen. Vom längeren Testzeitraum und der größeren Anzahl an Testdurchläufen im Berichtszeitraum verspricht man sich statistische Anomalien zu eliminieren und Ausreißer der Produkte auszubügeln.

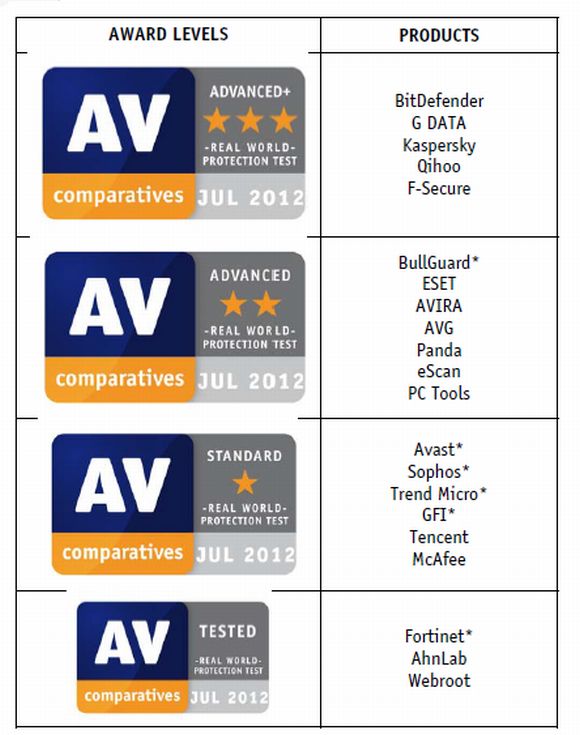

AV Comparatives vergibt aber auch halbjährlich nicht einzelne Plätze, sondern fasst die getesteten Programme zu Gruppen zusammen: Die Produkte lägen oft so nahe beieinander, dass es einen falschen Eindruck erwecke sie in eine Rangfolge zu bringen. Die Besten erhalten das Siegel Advanced+, die nächste Gruppe bekommt die Auszeichnung “Advanced”. Der Rest muss sich mit “Standard” oder einfach “Tested” zufriedengeben.

Produkte und Ergebnisse im Überblick

Für den aktuellen Bericht (PDF) standen in den vergangenen vier Monaten 21 Produkte auf dem Prüfstand. Damit hat AV Comparatives auf alle Fälle eine für den Markt repräsentative Anzahl von Herstellern und Produkten geprüft. Darunter befinden sich – außer von Symantec und Microsoft – Produkte von allen im deutschen Markt relevanten Anbietern.

Zu beachten ist allerdings, welches Produkt die Hersteller ins Rennen geschickt haben: Beispielsweise mussten sich bei Avast und Panda die kostenfreien Produkte bewähren, Avira hat dagegen die Kaufversion Internet Security 2012 und nicht das werbefinanzierte Produkt auf den Prüfstand stellen lassen. Das ist keine willkürliche Auswahl des Labors, sondern auf den Wunsch der Hersteller zurückzuführen.

Am besten haben BitDefender Internet Security 2012, G Data Internet Security 2012, Kaspersky Internet Security 2012, F-Secure Internet Security 2012 und die chinesische Software Quihoo 360 Internet Security 3.0 abgeschnitten. Diese fünf Produkte erreichten eine “Schutzrate” von über 99 Prozent und bekamen die Auszeichnung “AV Comparatives Advanced+”.

BullGuard Internet Security 2012 hätte die auch bekommen können, meldete aber zu viele False Positives. Das Softwarepaket wurde daher auf Advanced herabgestuft. Dieselbe Auszeichnung bekamen Eset Smart Security 5.0, Avira Internet Security 2012, AVG Internet Security 2012, Panda Cloud Free Antivirus 1.5.2, eScan Internet Security 11.0 und PC Tools Internet Security 2012.