Big Data ist auch von kleinen Unternehmen zu stemmen

Wenn man bedenkt, wie viele kleine Unternehmen sich den Begriff Big Data mittlerweile zu Nutze machen beziehungsweise aus großen und komplexen Datenvolumen Geschäft generieren, dann steckt mehr Potenzial dahinter. Jedoch müssen Unternehmen insbesondere am Anfang strategisch mit Investitionen vorgehen.

Facebook feierte dieser Tage sein neunjähriges Bestehen – und das mit weltweit knapp einer Milliarde Nutzern; es ist mittlerweile das größte soziale Netzwerk. Waren es am Anfang noch wenige Profile, so verwaltet der Social-Network-Riese inzwischen riesige Datenmengen. An die 2,5 Milliarden Inhalte, 2,7 Milliarden Likes und 300 Millionen Fotos sind es täglich. Unter dem Strich ist das ein Datenvolumen von mehr als 500 Terabyte, das täglich auf über 180.000 Servern verwaltet wird. Das ist “Big Data” und beruht auf einer kleinen Idee.

Lohnt sich Big Data für mein Unternehmen?

Sicherlich sind Facebook, aber auch Amazon oder Google, Paradebeispiele für ein Big-Data-Szenario und auch bezeichnend für den großen Erfolg einer kleinen Idee. Doch während man damals noch am Erfolg irgendeiner Idee zweifelte, so weiß man heute, dass auf lange Sicht ein solches Vorhaben, bei dem Big Data eine Rolle spielt, sich durchaus lohnen kann.

Ende letzten Jahres veröffentlichte der Bitkom eine Statistik darüber, dass der weltweite Markt für Big Data um über 30 Prozent auf 4,5 Miliarden Euro wachsen wird. 2016 soll der globale Big-Data-Markt sogar knapp 16 Milliarden Euro umfassen. Der Trend zu Big Data unterstreiche die Bedeutung von Daten als Faktor der Wertschöpfung, die in der digitalen Welt zum wichtigsten Produktionsfaktor werden, so der Verband.

Auch das Fraunhofer-Institut für Intelligente Analyse- und Informationssysteme IAI beleuchtete das Thema Big Data und hat bekannt gegeben, dass im vergangenen Jahr weltweit 1,8 Zettabyte an Daten produziert wurden. Prognosen zufolge verdoppelt sich das Volumen alle zwei Jahre.

Prognostisch und prädiktiv wie Forrester Research ist, belegt das Marktforschungsunternehmen in einer zwar etwas älteren aber immer noch gültigen Umfrage zu Big Data von Juni 2011, die Thesen von Bitkom und Fraunhofer IAI. Unter dem Strich: 70 Prozent der Teilnehmer sagten, dass Big Data und die damit verbundenen Geschäftschancen nur gemeinsam zwischen Business und IT synergetisch zu bewältigen sind.

Aber während Industrieexperten und Analysten weiterhin Statistiken über exponentiell steigende Datenmengen veröffentlichen, die jeden Tag und jede Minute produziert werden, bleibt eine Tatsache bestehen: Das wichtigste Gut eines Unternehmens ist wohl die Sammlung von dessen Daten, und mit jedem Teilerfolg eines Unternehmens steigt auch die Menge der Informationen, beispielsweise wenn deren Kunden beziehungsweise User weitere Spuren im Internet bei Transaktionen, Social Networking oder mobiler Nutzung via Endgeräten hinterlassen.

Fakt ist, dass all diese Daten – egal wie unstrukturiert sie am Anfang erscheinen mögen – wertvolle Information enthalten können. Und aus diesen Informationen können wiederum Rückschlüsse gezogen oder weitere Entscheidungsprozesse angestoßen werden. Unternehmen, die es verstehen, diese unstrukturierten Daten zu ordnen und entsprechende Strategie- und Lösungsansätze ableiten, können sich agil auf neue Kunden- und Marktsituationen einstellen sowie Möglichkeiten für Geschäftsoptimierungen wahrnehmen, die zu einem signifikanten Wettbewerbsvorteil führen können.

Auf die Lösung kommt es an

Mit dem Wissen als Hintergrund und mit dem richtigen datenzentrischen Geschäftsmodell können kleinere Unternehmen also mit dem Erfolg auf lange Sicht rechnen. Doch lohnt es sich jetzt schon, gerade am Anfangsstadium, eine IT-Infrastruktur aufzubauen, die bereits heute Petabyte an Daten bewältigen kann? Unternehmen müssen strategisch vorgehen. Die zentrale Frage an der Stelle ist auch: Welches System ist am besten geeignet, um die Datenflut zu bewältigen und um einen größtmöglichen Nutzen herauszuholen?

Es gibt Lösungen auf dem Markt, die hohe Performance anbieten, ohne zunächst in große Server- beziehungsweise Speicherlandschaften zu investieren. Um im Nachhinein die Leistung nach oben zu schrauben, bedarf es weiterer Server. Auf der anderen Seite gibt es Technologien, die sich die Leistungsfähigkeit moderner, gängiger CPUs voll zu Nutze machen. Sie beinhalten eine Datenbank-Engine, die gegenüber herkömmlichen Datenbanken durch eine Vektor-basierte Verarbeitung und On-Chip Memory-Funktion signifikante Leistungssteigerungen für Abfragen und Analysen in Echtzeit erzielen kann.

Systeme, die Möglichkeiten moderner Prozessoren wie SSE, Out of Order Execution, Chip-Multithreading und immer größer werdende L2- und L3-Caches nutzen, können so die Analyse großer Datenmengen beschleunigen. Letztendlich sollen sich mit geringen Hardwareressourcen auch große Datenmengen analysieren lassen. Ein einzelner Server reicht aus, um mehrere Terabyte an Daten zu verarbeiten.

Und hier ist der Ansatz: Meist haben kleinere Unternehmen eine IT-Ausstattung, bestehend aus herkömmlicher Hardware und vielleicht noch einem NAS-Server, um Daten für jedermann im Netzwerk zugänglich zu machen. Um in Unternehmen in die Big-Data-Analyse einzuführen, muss zunächst in eine analytische Technologie und das entsprechende Personal mit Know-how investiert werden. Denn die Menge der verfügbaren Daten scheint schneller zu wachsen, als die Fähigkeit, damit umzugehen.

Die Kosten lassen sich jedoch immer im Rahmen halten, wenn eine Lösung eingesetzt wird, die bei ihrer Verwendung keinen großen Aufwand voraussetzt. Also leicht zu bedienende Datenbanken, die blitzschnelle Performance liefern, und zwar nicht nur bei der Analyse von großen Daten, sondern auch bei der Einspeisung der Daten. Die Einfachheit einer Lösung ist aber nicht zu unterschätzen – Für eine Kostentransparenz einer Big-Data-Lösung spielen verschiedene Faktoren eine wesentliche Rolle:

- Wie viele Daten sollen analysiert werden?

- Was sind das für Daten (strukturierte, unstrukturierte, Grafiken, Video und so weiter)?

- Wie viele Mitarbeiter müssen auf die Daten und auch die Analysen gleichzeitig zugreifen können?

- Was ist das geschäftliche Ziel einer Big Data-Lösung? Worauf will man mit der Lösung hinaus?

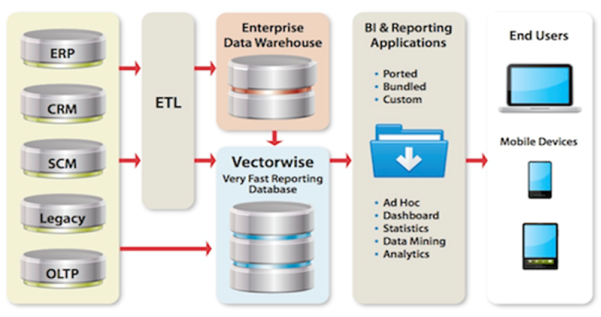

Erkenntnisse aus diesen Fragen und den damit verbundenen aggregierten Daten zu ziehen, auf Eventualitäten vorbereitet zu sein und auf unerwartete Veränderungen reagieren zu können, sind nur einige Anforderungen einer entsprechenden Lösung. Es bringt also nichts, Big Data nur in einem Data Warehouse zu verwalten, sondern es muss mittels Business Intelligence auch darum gehen, Gewinne zu maximieren und Kosten zu minimieren.

Herkömmliche BI-Lösungen eignen sich insbesondere für die Analyse von eher kleineren Datenmengen, die Datenanfragen sukzessive abarbeiten und die grafische Darstellung der Ergebnisse erst im Nachhinein aufbereitet. Viel besser ist es, eine analytische Datenbank beziehungsweise eine BI-Applikation zu verwenden, die alle Daten gleichzeitig und auch in Echtzeit analysieren kann. Hier stoßen allerdings viele herkömmliche BI-Lösungen an ihre Grenzen.

Aber bereits getätigte BI-Investitionen können für Big Data immer noch beansprucht werden, indem man die analytische Datenbankschicht unter der BI-Applikation einfach ändert. Das heißt, man kann dieselbe BI-Applikation (zum Beispiel Tableau Software, MicroStrategy, Yellowfin und so weiter) verwenden, wenn man sie mit einer schnelleren analytischen Datenbank kombiniert.

Wichtig ist zu erwähnen, dass bereits installierte Datenbanken (zum Beispiel Oracle, SQL Server und so weiter) nicht deinstalliert werden müssen. Diese können nach wie vor für transaktionale Aufgaben verwendet werden. Wenn es aber um analytische Aufgaben geht, kann man eine analytische Datenbank gleichzeitig verwenden und die Daten, die zu analysieren sind, aus der transaktionalen Datenbank in die analytische Datenbank einspeisen – auf dieser Art und Weise sind bereits getätigte Investition in Technologie gewährleistet.

Nur wer Big Data richtig einsetzt, wird langfristig Erfolg haben

Angesichts der sich weltweit weiter ausbreitenden digitalen Revolution und der Tatsache, dass Unternehmen immer größere und komplexere Datenmengen aus den verschiedensten Quellen erfassen – sei es aus sozialen Netzwerken ebenso wie aus digitalen Verhaltensmustern, Trends und Online-Konversationen –, steigt die Datenflut exponentiell. Unternehmen müssen Big Data annehmen, sollten aber zunächst wissen, was sie geschäftlich erzielen wollen, ehe sie die passende Technologie auswählen – also wie sie mit Big Data umgehen wollen, wie sie das Beste aus den Datenmengen machen und auch zu welchem Zweck.

Der Autor:

Dr. Marcus Oliver Menzel ist Sales Director bei Actian Central Europe (früher als Ingres bekannt) und war zuvor jahrelang bei Unternehmen wie Oracle, Siebel und Jaspersoft.